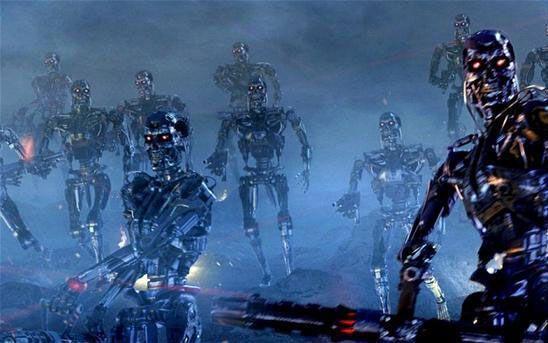

自從(cong) “源”覺醒後,人工智能機器人逐漸控製了全球,然而創造它們(men) 的人類卻成了機器人的獵物。“源”勢必要清除所有人類,完全、徹底地掌控地球資源。所剩無幾的人類聯合起來與(yu) 人工智能做殊死一搏……

這是很多有關(guan) 人工智能的科幻片裏的經典橋段。雖說電影是一種藝術,但它也是源於(yu) 生活,而人工智能所帶來的“威脅”,在現實生活中也不容小覷。

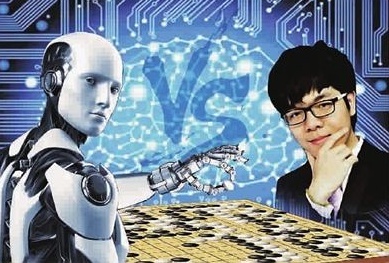

2017年5月,中國烏(wu) 鎮圍棋峰會(hui) 上,圍棋人工智能程序阿爾法狗(AlphaGo)以3比0大敗中國棋手柯潔。彼時,柯潔排名世界第一,代表著人類在最複雜棋盤遊戲——圍棋上的最高智慧。

阿爾法狗的取勝使人工智能威脅論再一次甚囂塵上,小報編輯甚至挖出了近三十年前的一樁命案。

1989年,前蘇聯國際象棋冠軍(jun) 尼古拉·古德科夫在與(yu) 一台巨型計算機對弈時,被連輸三局“惱羞成怒”的計算機放電“謀殺”。經過專(zhuan) 家深入調查,最終證實不是巨型計算機“蓄意”所為(wei) ,而是因為(wei) 外部電磁波幹擾了計算機程序所致。

就在不久前,人工智能“傷(shang) 害”人類的事件還在我國上演了。2016年11月在深圳高交會(hui) ,一個(ge) 名為(wei) “小胖”的機器人,在“沒有指令”的情況下,開始打砸展台玻璃,並砸傷(shang) 路人,一位路人全身多處劃傷(shang) 後被擔架抬走,該傷(shang) 者在醫院,腳踝被縫了兩(liang) 針。

毫無疑問,這次事件又被各種媒體(ti) 大炒特炒,“機器人不滿高強度工作,蓄意發泄報複……”事後,官方發表聲明:“這次事件是因為(wei) 工作人員操作不當,誤將“前進鍵”當成“後退鍵”所致”。

一次烏(wu) 龍事故又使人工智能威脅論成為(wei) 了人們(men) 茶餘(yu) 飯後的談資。機器人與(yu) 人類究竟該如何相處,有什麽(me) 法則來規範他們(men) 嗎?

還真有對機器人的行為(wei) 作出規範的原則——“機器人三原則”。

它是由著名科普作家、文學評論家阿西莫夫在1940年前瞻性地提出的。

第一條,機器人不得傷(shang) 害人類,或看到人類受到傷(shang) 害而袖手旁觀。

第二條,機器人必須服從(cong) 人類命令,除非這條命令與(yu) 第一條相矛盾。

第三條,機器人必須保護自己,除非這種保護與(yu) 以上兩(liang) 條相矛盾。

隨後,學界在機器人的這三條鐵律上又陸續補充了“元原則”、“第零原則”、“繁殖原則”等等。確保未來人工智能機器人與(yu) 人類和諧共處,成為(wei) 人類的好幫手,永遠為(wei) 人類所用。

不知大家注意到沒有,小編在行文時,在人工智能上使用的有主觀色彩的詞語如“惱羞成怒”、“蓄意”、“不滿”等,都是加了引號的。因為(wei) 隻有人類才具有複雜的主觀感情,才有喜怒哀樂(le) 。人工智能是否能思考,機器人是否擁有人類的智能?

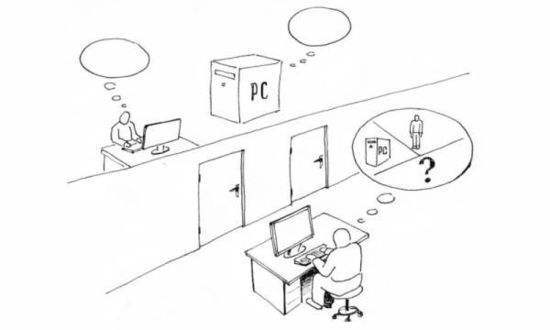

想知道答案。那它必須先通過一項偉(wei) 大的測試——圖靈測試。

圖靈測試是由英國數學家、邏輯學家、“人工智能之父”艾倫(lun) ·麥席森·圖靈在1950年提出的。圖靈測試旨在檢測人工智能機器人是否能思考。

經過多次測試後,如果機器能讓平均每個(ge) 參與(yu) 者做出超過30%的誤判,則它通過測試。

圖靈測試問世後一直沒有機器能夠通過,直到2014年6月,一位“13歲烏(wu) 克蘭(lan) 男孩”出現在英國皇家學會(hui) 舉(ju) 行的圖靈測試大會(hui) 上……

我們(men) 下次再聊。

(轉載請取得授權,否則必究;本文圖片源於(yu) 網絡,感謝原作者,若有侵權聯係刪除)

歡迎掃碼入群!

深圳科普將定期推出

公益、免費、優(you) 惠的活動和科普好物!

- 參加最新科普活動

- 認識科普小朋友

- 成為科學小記者

會員登錄

會員登錄

深圳市華強北街道 華新地鐵站A1出口24小時科學銀行

深圳市華強北街道 華新地鐵站A1出口24小時科學銀行