版權歸原作者所有,如有侵權,請聯係我們(men)

ChatGPT 等大型語言模型(LLM)的出現,讓機器人具備了如同人類一般的語言表達能力。然而,機器人在與(yu) 人類交談時,其麵部表情卻依然顯得很不自然,甚至充滿了恐懼感。

這無疑會(hui) 阻礙人與(yu) 機器溝通的意願,讓兩(liang) 者的溝通變得十分困難。

因此,在未來人機共存的時代,設計一個(ge) 不僅(jin) 能做出各種麵部表情,而且知道何時使用這些表情的機器人,至關(guan) 重要。

如今,來自哥倫(lun) 比亞(ya) 大學的研究團隊及其合作者便邁出了重要一步——製造了一個(ge) 披著矽片、能夠預測人類麵部表情並同步執行表情的機器人 Emo。它甚至可以在人類微笑前約 840 毫秒(約 0.9 秒)預測即將出現的微笑。

據介紹,它能與(yu) 人進行眼神交流,並利用兩(liang) 個(ge) 人工智能(AI)模型在人微笑之前預測並“複製”人的微笑。研究團隊表示,這是機器人在準確預測人類麵部表情、改善互動以及建立人類與(yu) 機器人之間信任方麵的一大進步。

相關(guan) 研究論文以“Human-robot facial coexpression”為(wei) 題,已於(yu) 今天發表在科學期刊 Science Robotics 上。哥倫(lun) 比亞(ya) 大學機械工程係博士 Yuhang Hu 為(wei) 該論文的第一作者和共同通訊作者,他的導師、哥倫(lun) 比亞(ya) 大學教授 Hod Lipson 為(wei) 該論文的共同通訊作者。

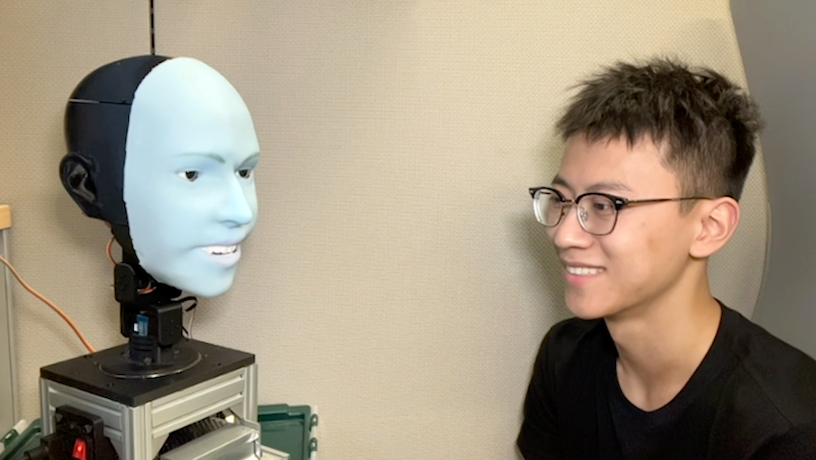

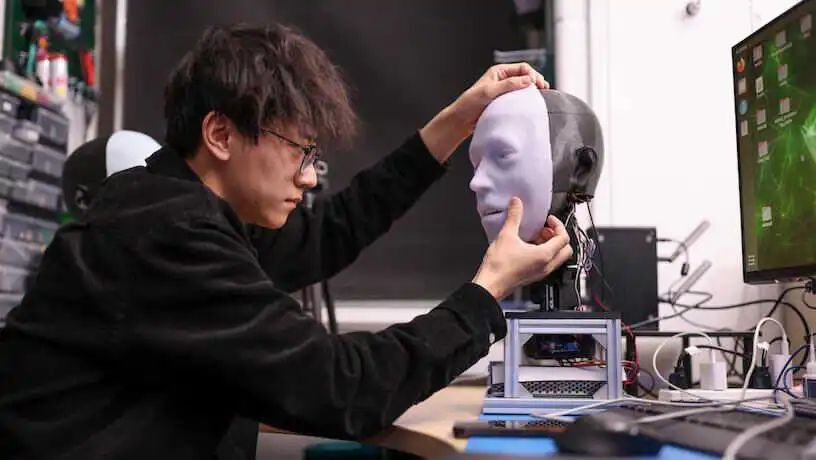

圖|Yuhang Hu 與(yu) Emo 麵對麵。(來源:Creative Machines Lab)

在一篇同期發表在 Science Robotics 的 FOCUS 文章中,格拉斯哥大學計算社會(hui) 認知教授 Rachael Jack 評價(jia) 道:

“人類社交互動本質上是多模式的,涉及視覺和聽覺信號的複雜組合,雖然 Hu 及其同事的研究集中在單一模式——麵部表情上,但他們(men) 的成果在為(wei) 開發更複雜的多模態信號的社交同步技能方麵做出了巨大的貢獻。”

在她看來,盡管這是一個(ge) 複雜的跨學科工作,但“真正使社交機器人融入人類社交世界是可能的”。

Emo 微笑了,但也不僅(jin) 僅(jin) 是“微笑”

如果你走到一個(ge) 長著人類腦袋的機器人麵前,它先對你微笑,你會(hui) 怎麽(me) 做?你很可能會(hui) 回以微笑,也許會(hui) 覺得你們(men) 兩(liang) 個(ge) 在真誠地交流。

但是,機器人怎麽(me) 知道如何做到這一點呢?或者更好的問題是,它怎麽(me) 知道如何讓你回以微笑?

為(wei) 此,Yuhang Hu 及其同事需要解決(jue) 兩(liang) 大難題:一是如何以機械方式設計一個(ge) 表情豐(feng) 富的機器人麵部,這涉及複雜的硬件和執行機製;二是知道該生成哪種表情,以使它們(men) 看起來自然、及時和真實。

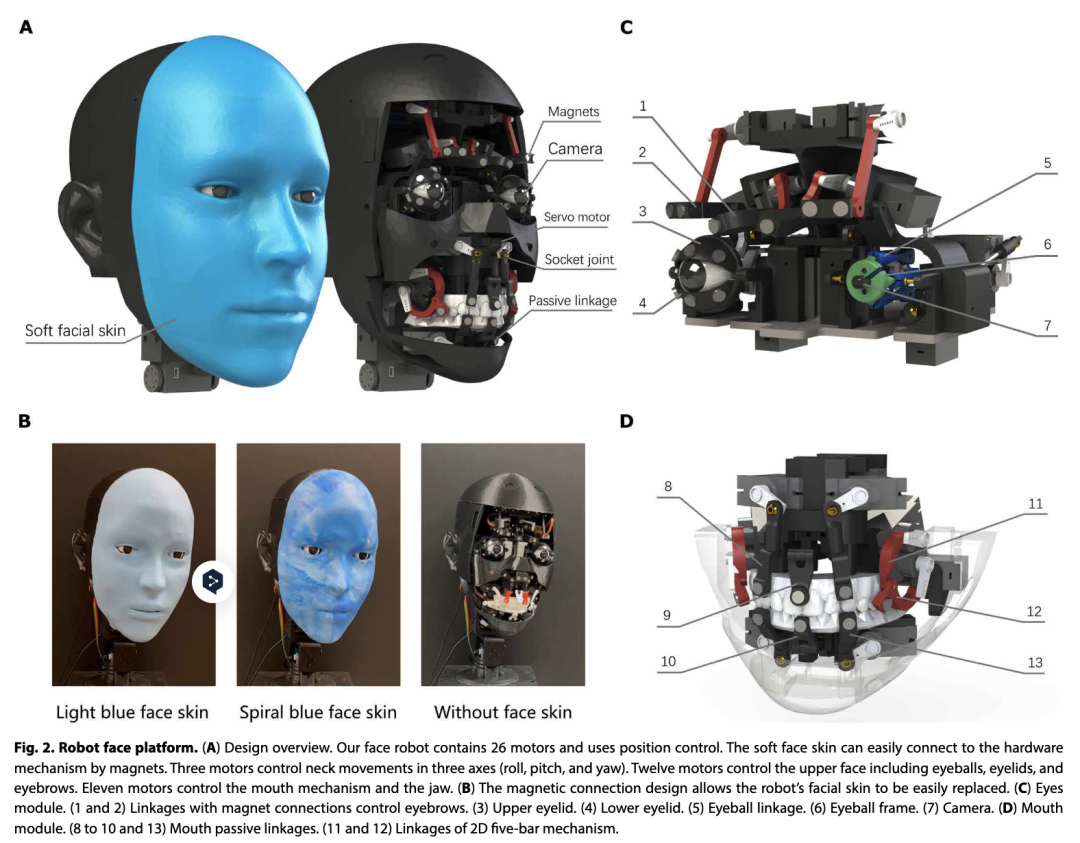

據論文描述,Emo 配備了 26 個(ge) 致動器,頭部覆蓋有柔軟的矽膠皮膚,並配有磁性連接係統,從(cong) 而便於(yu) 定製和快速維護。為(wei) 了實現更逼真的互動,研究團隊在 Emo 每隻眼睛的瞳孔中都集成了高分辨率攝像頭,使其能夠進行眼神交流,這對非語言交流至關(guan) 重要。

圖|Robot face 平台

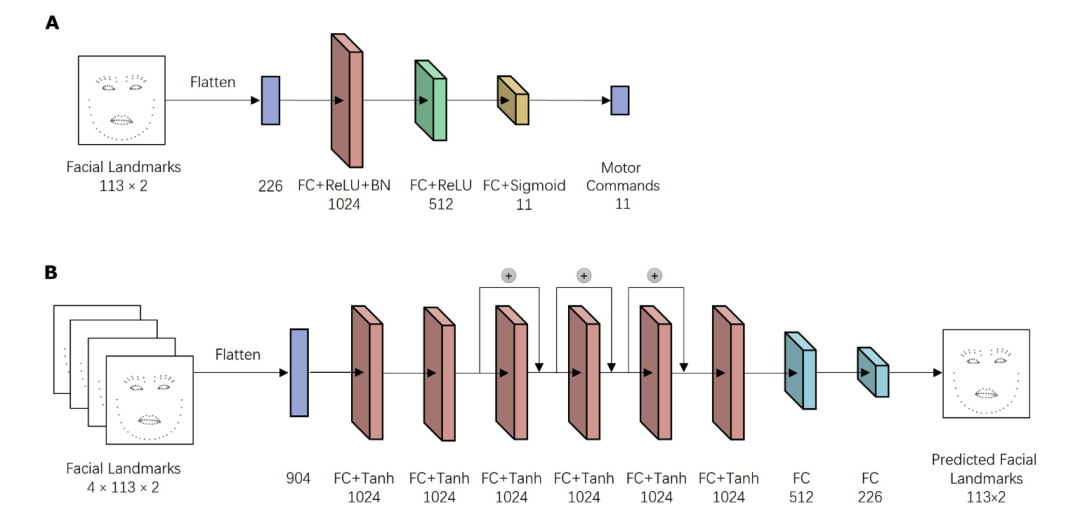

另外,他們(men) 還開發了兩(liang) 個(ge) 人工智能模型:其中一個(ge) 通過分析目標麵部的細微變化預測人類麵部表情,另一個(ge) 則利用相應的麵部表情生成運動指令。第一個(ge) 模型是通過觀看網絡視頻進行訓練的,而第二個(ge) 模型則是通過讓機器人觀看自己在實時攝像機畫麵上的表情來訓練的。他們(men) 通過與(yu) 其他基線進行定量評估,證明了這兩(liang) 個(ge) 模型的有效性。

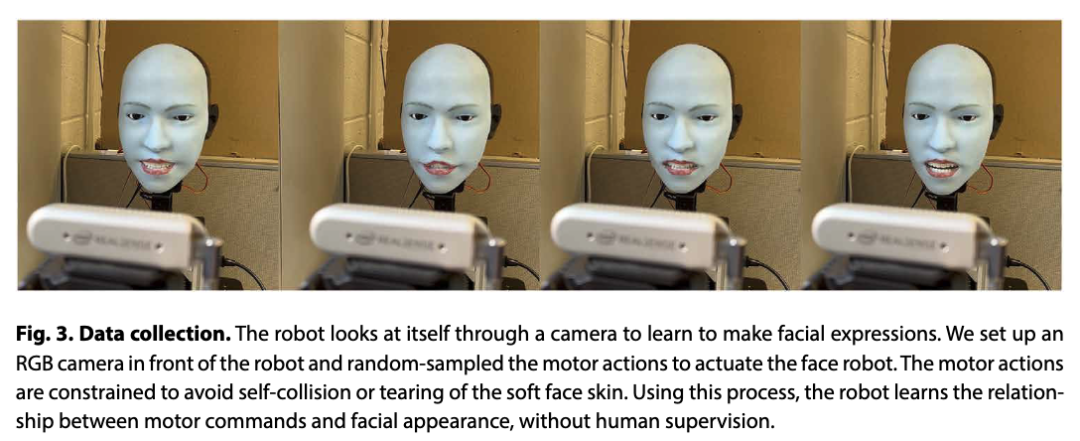

圖|模型架構。逆向模型(A)和預測模型(B)

為(wei) 了訓練 Emo 學會(hui) 做出麵部表情,研究團隊把 Emo 放在攝像頭前,讓它做隨機動作。幾個(ge) 小時後,Emo 就學會(hui) 了麵部表情與(yu) 運動指令之間的關(guan) 係——就像人類通過照鏡子練習(xi) 麵部表情一樣。他們(men) 將其稱為(wei) “自我建模”——類似於(yu) 人類想象自己做出特定表情時的樣子。

然後,研究團隊播放人類麵部表情的視頻,讓 Emo 逐幀觀察。經過幾個(ge) 小時的訓練後,Emo 便可以通過觀察人們(men) 麵部的微小變化來預測他們(men) 的麵部表情。

在 Yuhang Hu 看來,準確預測人類的麵部表情是人機交互技術的重要突破,“當機器人與(yu) 人進行實時表情交互時,不僅(jin) 能提高交互質量,還有助於(yu) 建立人與(yu) 機器人之間的信任。未來,在與(yu) 機器人互動時,機器人會(hui) 像真人一樣觀察和解讀你的麵部表情。”

值得一提的是,這項研究的潛在影響或許已經超越機器人學,擴展到神經科學和實驗心理學等領域。

例如,一個(ge) 可以預測和同步麵部表情的機器人係統可以作為(wei) 研究鏡像神經元係統的工具。通過在測量大腦活動的同時與(yu) 參與(yu) 者互動,研究人員可以深入了解社會(hui) 互動和交流的神經相關(guan) 性。

在心理學領域,具有預測和同步麵部表情能力的機器人可用作教育工具,幫助自閉症患者發展更好的社交溝通技能。已有研究表明,機器人可以有效地吸引患有自閉症譜係障礙(ASD)的兒(er) 童,促進他們(men) 的社交互動。

不足與(yu) 展望

盡管 Emo 已經可以預測人類麵部表情並同步快速回應,但遠不具備完全捕捉到人類的麵部交流能力,甚至在由成人模樣的機器人進行模仿時,可能會(hui) 讓人感覺厭惡。

然而,研究團隊認為(wei) ,就像嬰兒(er) 在學會(hui) 模仿父母之後才能獨立做出麵部表情一樣,機器人必須先學會(hui) 預測和模仿人類的表情,然後才能成熟地進行更加自發和自我驅動的表情交流。

在未來的工作中,他們(men) 希望擴大 Emo 的表情範圍,並希望訓練 Emo 根據人類所說的話做出表情。他們(men) 正在努力將語言交流整合到 Emo 中,並接入類似 ChatGPT 的大型語言模型。

然而,他們(men) 也表示,必須謹慎選擇機器人模仿的麵部表情。例如,某些麵部姿態,如微笑、點頭和保持眼神接觸,通常會(hui) 自然地得到回應,並且在人類交流中會(hui) 被積極地看待。相反,對於(yu) 噘嘴或皺眉等表情的模仿則應謹慎,因為(wei) 這些表情有可能被誤解為(wei) 嘲諷或傳(chuan) 達非預期的情緒。

另外,人類用戶如何感知這些表情才是衡量成功與(yu) 否的最終標準。未來的一個(ge) 重要步驟是驗證這些表情在現實世界中人與(yu) 機器人在各種情境下互動時的情感效果,以確定其心理有效性。

此外,該研究也存在一定的局限性,其中之一為(wei) “模型的預測和表情模仿可能缺乏文化敏感性”。

眾(zhong) 所周知,不同的文化可能會(hui) 對某些麵部表情有不同的規範和含義(yi) 。例如,雖然在許多文化中,微笑通常被認為(wei) 是快樂(le) 或友好的標誌,但它也可能是尷尬或不確定的標誌。同樣,直接的目光接觸在某些文化中可能被視為(wei) 自信和誠實的表現,但在其他文化中卻可能被視為(wei) 粗魯或對抗。

未來的工作可以探索將文化背景融入到模型中,一個(ge) 可能的方法是納入來自不同文化背景的數據集,並在算法中融入對文化規範的理解。

圖|Yuhang Hu 在 Hod Lipson 的實驗室工作。(來源:John Abbott/哥倫(lun) 比亞(ya) 工程學院)

最後,一個(ge) 不能逃避的話題是,隨著機器人的行為(wei) 能力越來越像人類,研究團隊必須考慮與(yu) 這項技術相關(guan) 的倫(lun) 理問題。杜絕可能的技術濫用(如欺騙或操縱),需要強有力的倫(lun) 理框架和管理。

盡管如此,這一研究也著實令人十分興(xing) 奮。正如研究團隊所言:

“我們(men) 正逐步接近這樣一個(ge) 未來——機器人可以無縫融入我們(men) 的日常生活,為(wei) 我們(men) 提供陪伴、幫助,甚至是共鳴。想象一下,在這個(ge) 世界上,與(yu) 機器人互動就像與(yu) 朋友交談一樣自然和舒適。”

參考鏈接:

https://www.science.org/doi/10.1126/scirobotics.adi4724

https://www.science.org/doi/10.1126/scirobotics.ado5755

https://www.engineering.columbia.edu/news/robot-can-you-say-cheese

https://www.creativemachineslab.com/

歡迎掃碼關(guan) 注深i科普!

我們(men) 將定期推出

公益、免費、優(you) 惠的科普活動和科普好物!

- 參加最新科普活動

- 認識科普小朋友

- 成為科學小記者

會員登錄

會員登錄

深圳市龍華區玉翠社區高坳新村小廣場

深圳市龍華區玉翠社區高坳新村小廣場